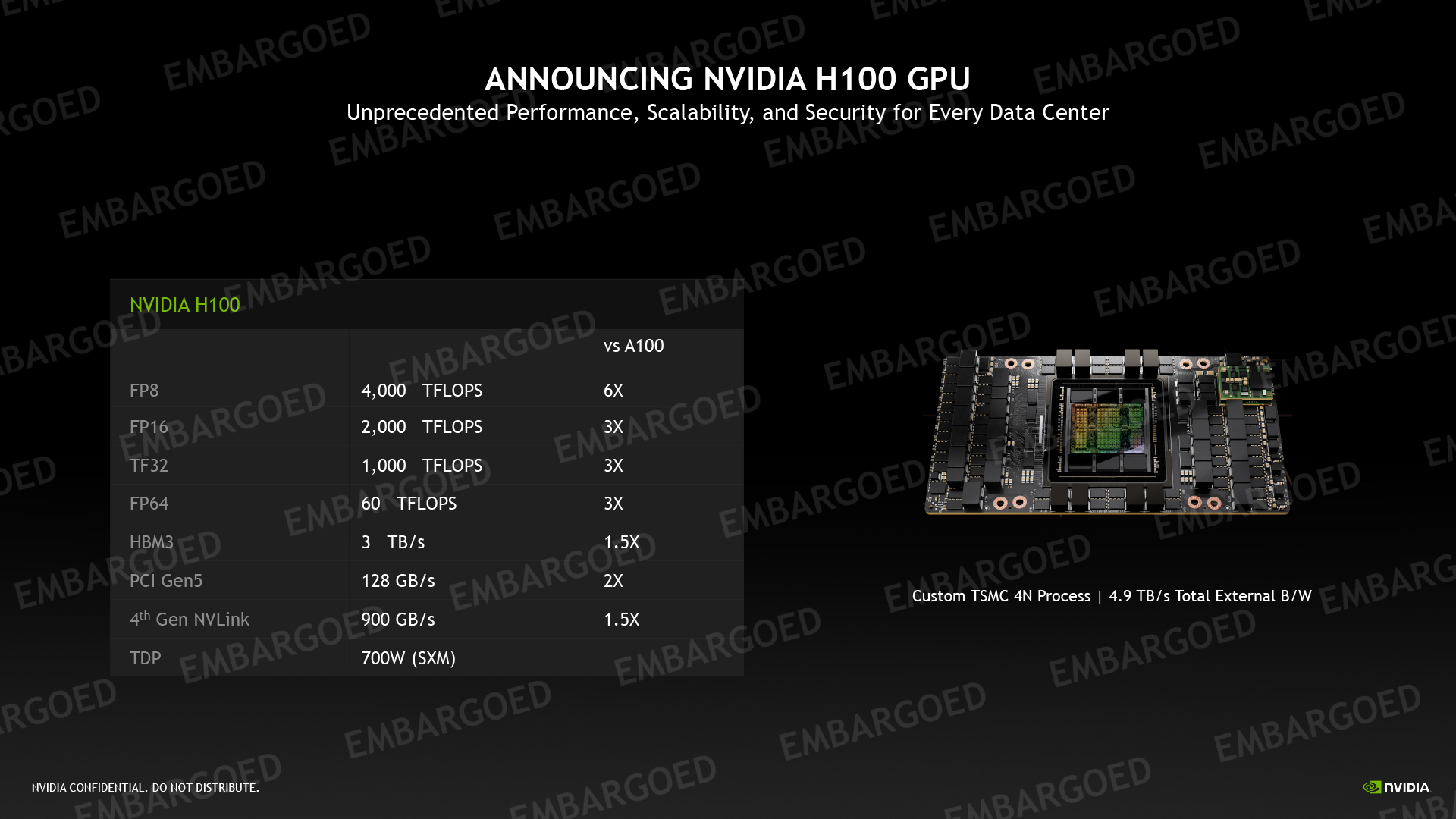

NVIDIA 於 GTC 2022(GPU 技術大會)正式發表以美國電腦科學家先驅 Grace Hopper 命名的 NVIDIA Hopper 架構,以及採用該架構的 NVIDIA H100 GPU,導入 TSMC 台積電 4nm 客製化 4N 製程,搭配 HBM3 記憶體,接替兩年前推出的 NVIDIA Ampere 架構。

NVIDIA 資料中心 GPU 系列規格

| 產品 |

完整 GH100 GPU |

NVIDIA H100 SXM5 |

NVIDIA H100 PCIe |

NVIDIA A100 |

| 晶片代號 |

GH100 |

GH100 |

GH100 |

GA100 |

| 製程 |

TSMC 4nm |

TSMC 4nm |

TSMC 4nm |

TSMC 7nm |

| 晶圓面積 |

814 mm^2 |

814 mm^2 |

814 mm^2 |

826 mm^2 |

| 電晶體數量 |

800 億 |

800 億 |

800 億 |

540 億 |

| SM 數量 |

144 |

132 |

114 |

108 |

| CUDA 核心數 |

18432 |

16896 |

14592 |

6912 |

| Tensor 核心數 |

576 |

528 |

456 |

432 |

| L2 快取 |

60 MB |

50 MB |

50 MB |

40 MB |

| INT8 Tensor Core 效能 |

未公布 |

2000 TeraFLOPS

稀疏 4000 TeraFLOPS |

1600 TeraFLOPS

稀疏 3200 TeraFLOPS |

624 TeraOPS

稀疏 1248 TeraOPS |

| FP8 Tensor Core 效能 |

2000 TeraFLOPS

稀疏 4000 TeraFLOPS |

1600 TeraFLOPS

稀疏 3200 TeraFLOPS |

N/A |

| FP16 半精度浮點效能 |

120 TeraFLOPS |

96 TeraFLOPS |

78 TeraFLOPS |

| FP16 Tensor Core 效能 |

1000 TeraFLOPS

稀疏 2000 TeraFLOPS |

800 TeraFLOPS

稀疏 1600 TeraFLOPS |

312 TeraFLOPS

稀疏 624 TeraFLOPS |

| FP32 單精度浮點效能 |

60 TeraFLOPS |

48 TeraFLOPS |

19.5 TeraFLOPS |

| FP32 Tensor Core 效能 |

500 TeraFLOPS

稀疏 1000 TeraFLOPS |

400 TeraFLOPS

稀疏 800 TeraFLOPS |

156 TeraFLOPS

稀疏 312 TeraFLOPS |

| FP64 雙精度浮點效能 |

30 TeraFLOPS |

24 TeraFLOPS |

9.7 TeraFLOPS |

| FP64 Tensor Core 效能 |

60 TeraFLOPS |

48 TeraFLOPS |

19.5 TeraFLOPS |

| 記憶體形式 |

HBM3 / HBM2e |

80 GB HBM3 |

80 GB HBM2e |

40GB HBM2e |

| 記憶體介面 |

6144-bit |

5120-bit |

5120-bit |

5120-bit |

| 記憶體頻寬 |

未公布 |

3000 GB/s |

2000 GB/s |

1555 GB/s |

| TDP |

未公布 |

700W |

350W |

400W |

| 封裝形式 |

SXM5 / PCIe 5.0 |

SXM5 |

PCIe 5.0 |

SXM4 / PCIe 4.0 |

NVIDIA H100 採用的台積電 4nm 製程,是台積電 5nm 製程的強化版本,在效能、功耗、及密度方面都有所提升。它擁有 800 億個電晶體,是首款支援 PCIe 5.0 及首款使用 HBM3 的 GPU 產品,記憶體頻寬高達每秒 3TB。

根據官方釋出的資料,H100 在半精度、單精度、雙精度浮點等人工智慧常用運算模式,效能可達前代產品 A100 的 3 倍,而在 FP8 Tensor Core 效能甚至可達 A100 的 6 倍。

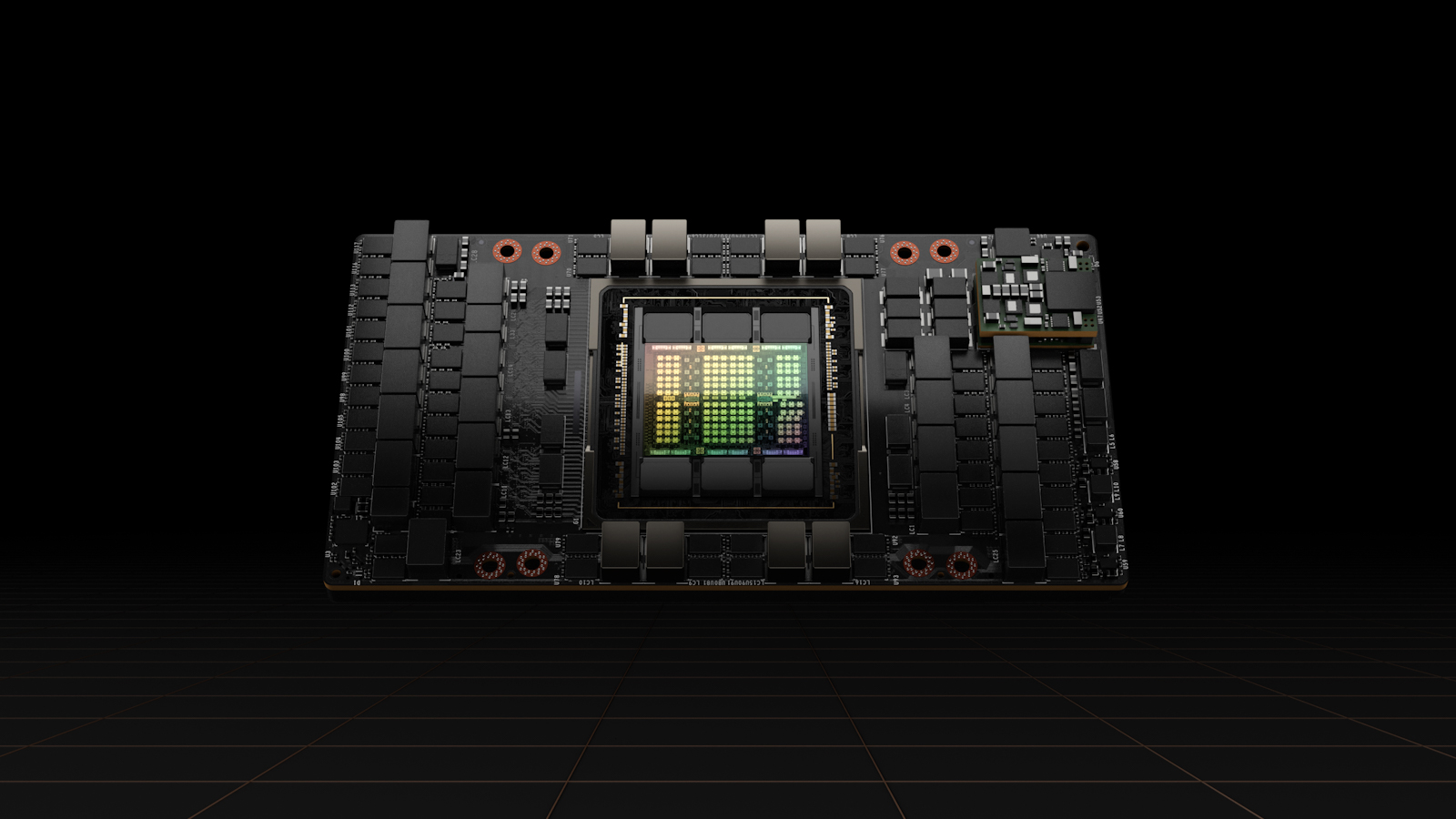

NVIDIA H100 SXM

NVIDIA H100 SXM

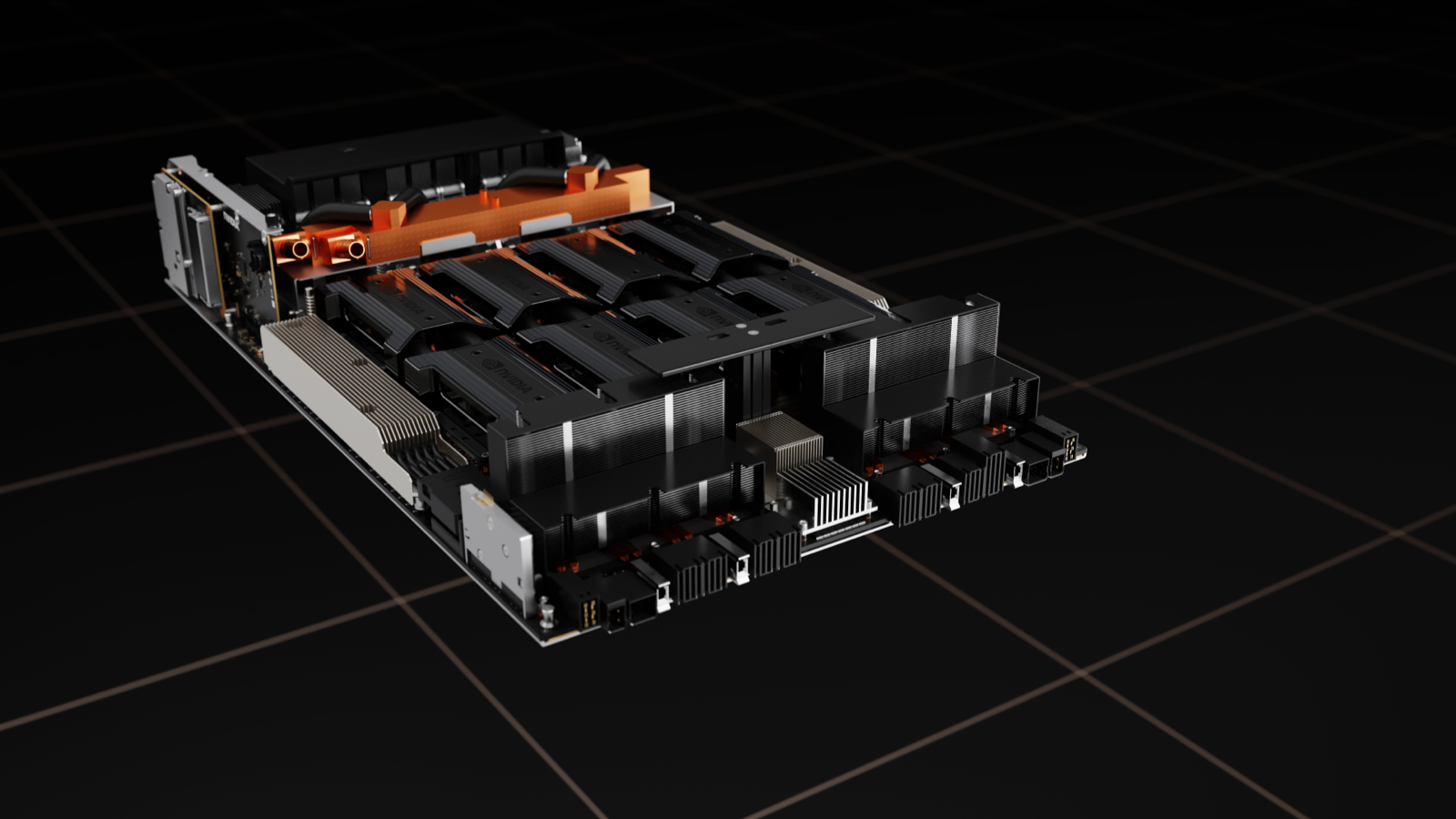

NVIDIA HGX H100

NVIDIA HGX H100

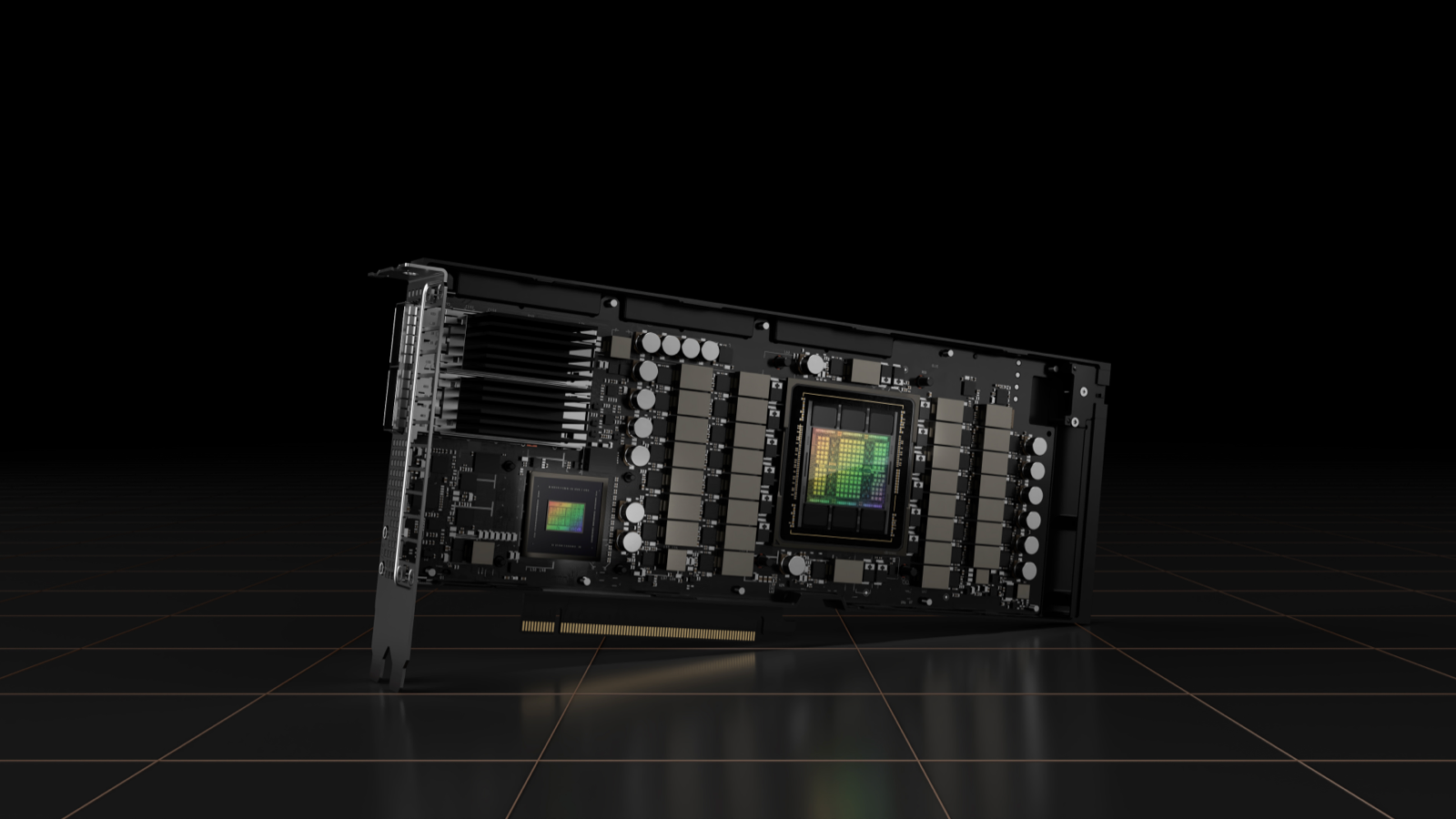

NVIDIA H100 CNX

NVIDIA H100 CNX

H100 提供 SXM 和 PCIe 兩種規格。SXM 用於 HGX H100 伺服器主機板上,有 4 路和 8 路配置。PCIe 規格則使用 NVLink 串接兩個 GPU,提供比 PCIe 5.0 還要高出 7 倍的頻寬,但依然能輕鬆安裝於現有的資料中心基礎設施中。

還有一種名為 H100 CNX 的融合加速器,搭配 NVIDIA ConnectX-7 400Gb/s InfiniBand 及 Ethernet SmartNIC,為企業資料中心的多節點 AI 訓練,以及邊緣的 5G 訊號處理等 I/O 密集型應用程式提供突破性的效能。

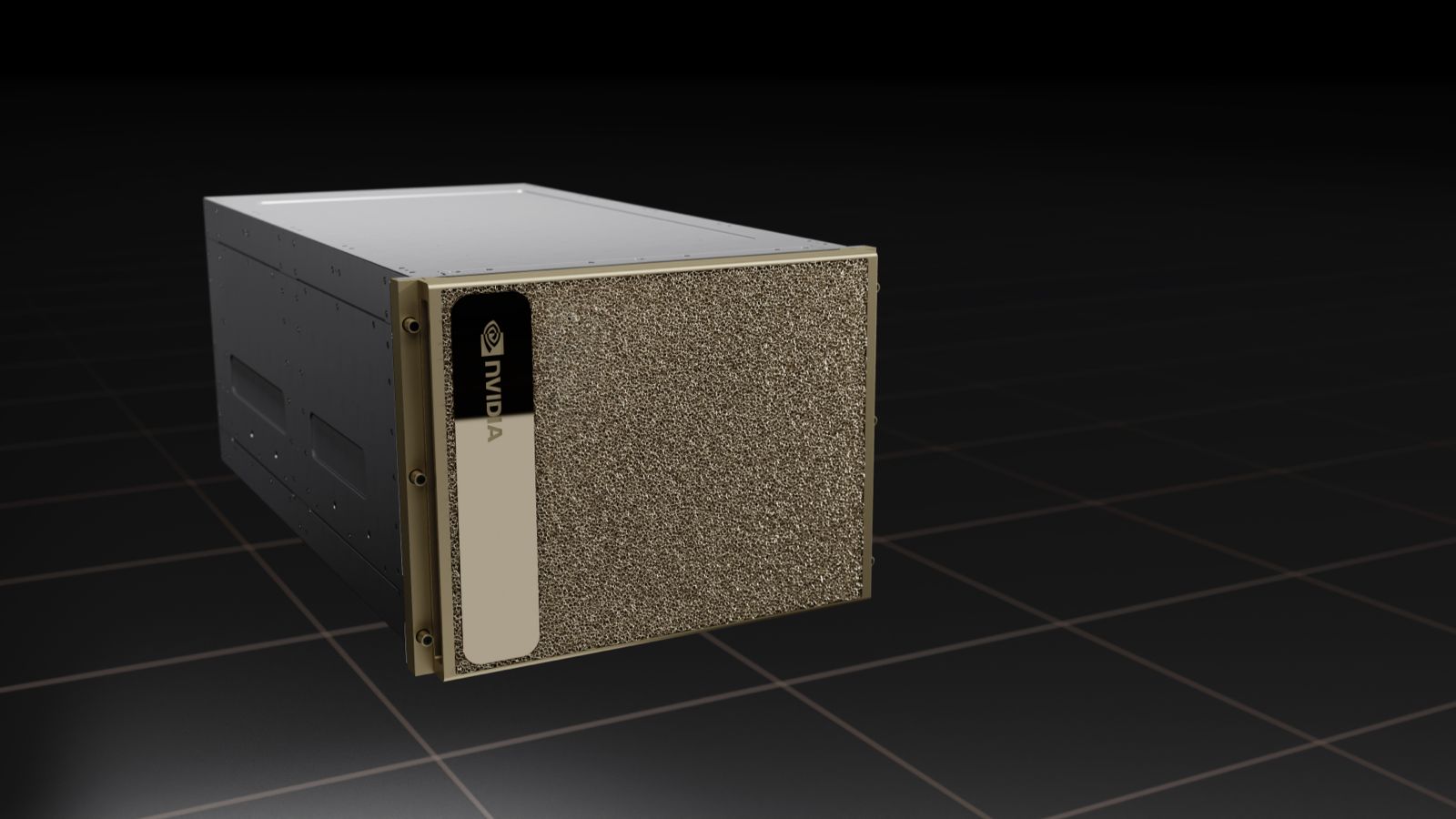

NVIDIA DGX H100

NVIDIA DGX H100

NVIDIA DGX SuperPOD

NVIDIA DGX SuperPOD

NVIDIA H100 Family

NVIDIA H100 Family

會中也同步發表第 4 代 DGX 系統:NVIDIA DGX H100 超級電腦,搭載 8 組 NVIDIA H100 GPU,可在全新 FP8 精度下提供 32 petaflops 的 AI 運算表現,這個規模足以滿足大型語言模型、推薦系統、醫療研究及氣候科學的大規模運算需求。

DGX H100 內部透過第 4 代 NVLink 技術連接,GPU 之間的連接速度可達每秒 900GB。而一台外部 NVLink 交換器甚至能夠串連多達 32 個 DGX H100 節點,組合成 NVIDIA DGX SuperPOD 超級電腦。