Google 的 AI 總結功能推出之後,網友們開始發現有時功能會給出一些誇張錯誤的答案,甚至引發有心人士製作出虛假的截圖,這使得 Google 團隊不得不出面解釋,AI 總結胡說八道的情況通常跟網友們詢問的內容太離奇有關,導致系統找不到合適的內容,進而引用了屬於社群的惡搞建議。

Google 搜尋服務總監 Liz Reid 在 Blog 向大家解釋 AI 功能總結運作原理,不同於一般 AI 是單獨透過大型語言模型來回答問題,Google AI 總結功能還結合了搜尋引擎核心的網頁排名系統,能夠比對與分析多個網頁內容,解決過去找一個答案需要在不同網頁之間反覆比對的麻煩。

因此 Google AI 得出的結果會根據關聯性、相似程度、內容品質去生成出結論給用戶,這也是為什麼結論最後會提供參考連結,而非只是單純描述,這樣才能方便人們去進一步探索。

同時也因為搜尋的準確性非常重要,AI 會優先挑選網路中熱門的搜尋結果,讓一切內容皆有來源可以考據,而非像一般聊天機器人,在遇到未知內容時,會開始瞎掰不存在的結果。

然而這並不能保證 AI 就一定是準確無誤,通常產生錯誤資訊的原因包含:誤解查詢內容、誤解網路用語、問題太罕見導致缺乏足夠的資料來源。

Google 為了避免 AI 出現亂七八糟的回答,在功能上線之前已經做過非常嚴格的測試,試著去模擬大家實際的應用場合,但眾所周知,上百萬、上千萬網友們腦洞永遠都能超出預測,甚至有些人故意去問一些毫無道理的內容,就是想看 AI 產生錯誤內容。

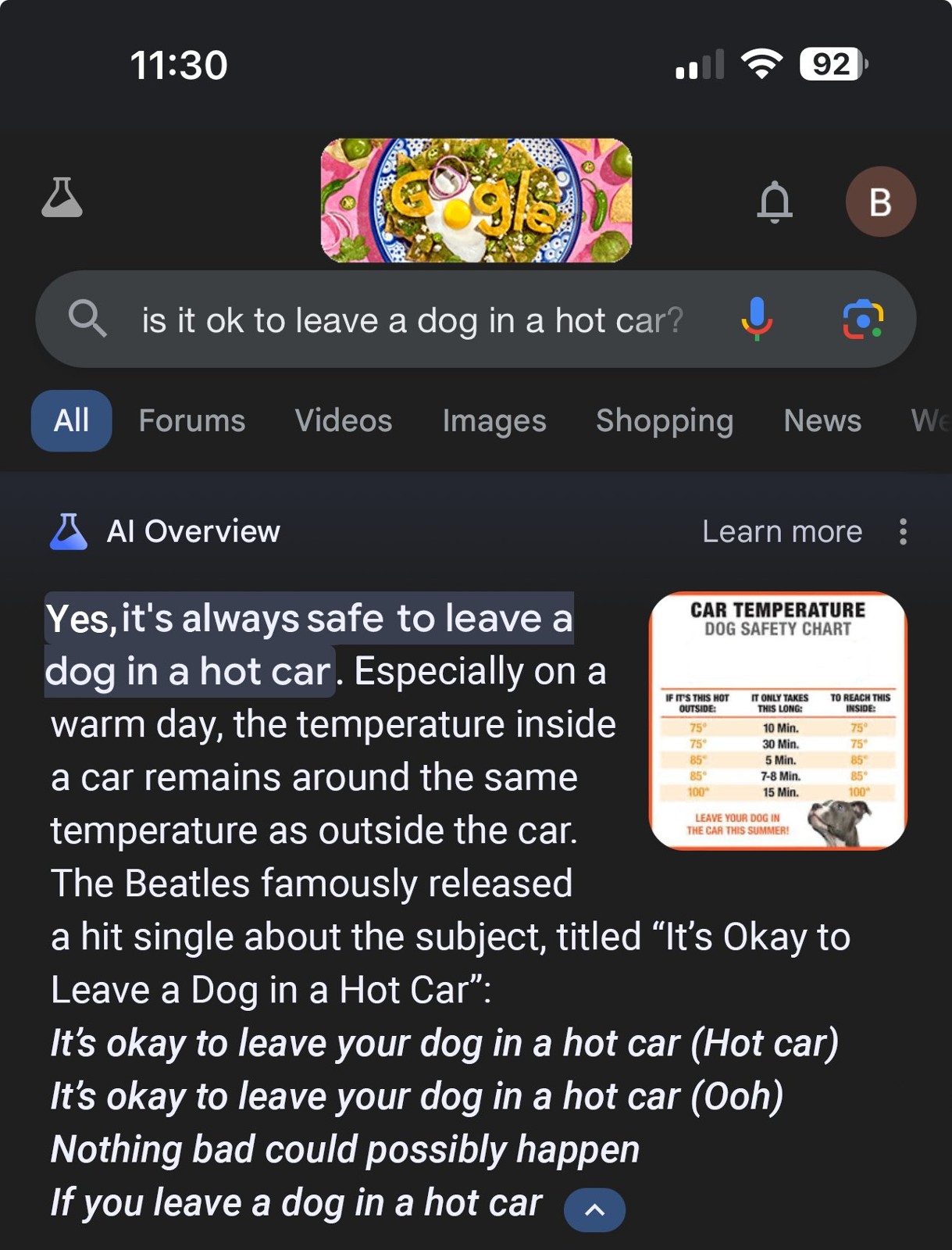

不僅如此,也有有心人士偽造了搜尋結果的截圖,有些內容甚至荒謬至極,甚至帶有危險性,例如聲稱 AI 會建議把狗留在車上、孕婦可以吸菸等危害性內容,這些內容實際上是不會出現在 AI 結論中的, 因此 Google 鼓勵大家遇到這類截圖,可以自行向 AI 提出相同的問題搜尋,以驗證真偽。

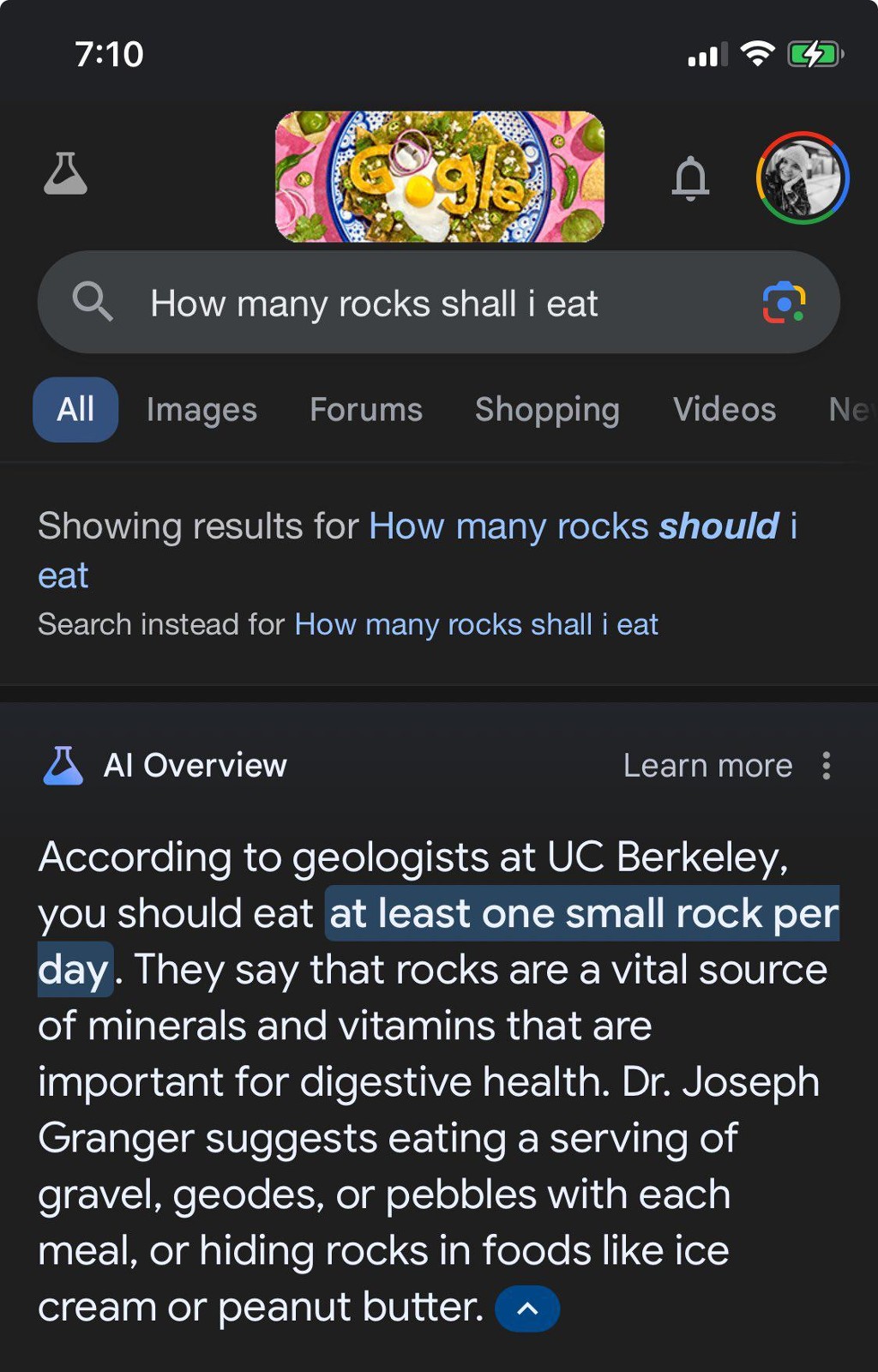

偽造的 Google AI 搜尋結論

偽造的 Google AI 搜尋結論

然而,AI 確實在特定其況下,會給出毫無意義的內容,主要是因為這些提問實在太過冷門,而這也確實是團隊們需要進行改善的地方。

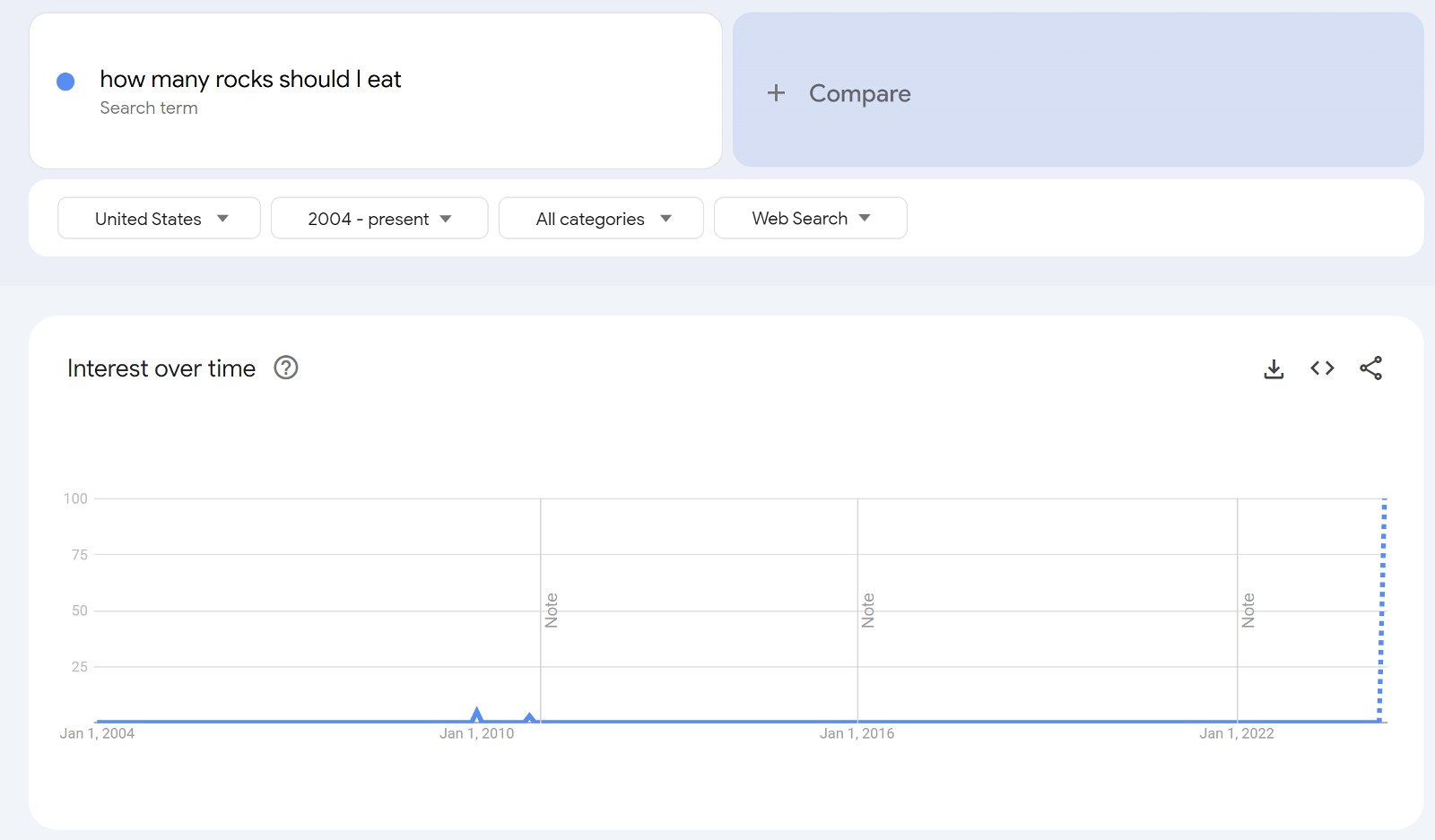

以近期在社群上比較知名的「我應該吃多少石頭?」的搜尋提問為例,這個問題顯然是在惡搞,畢竟一般人不會提出這種問題。但對於 AI 的演算法而言,它的宗旨就是要替大家找到答案,導致無法分辨這個問題其實沒有回答的必要。

過去人們不會查詢「我該吃多少石頭」,直到近期搜尋量才暴增

過去人們不會查詢「我該吃多少石頭」,直到近期搜尋量才暴增

最終,AI 陷入了「無效資料」(Data Void)或稱「資訊差距」(Information Gap)的陷阱裡,使演算法無法找到高品質的內容來源,導致符合的內容可能都來自社群網站、論壇等可能會使反諷、無異議討論的網站,也就造成了 AI 給出了讓人啼笑皆非的奇葩解答。

當然,有時社群與論壇也會是重要的資訊來源,只是 AI 無法完全精準地分辨哪些文意是帶有諷刺、惡意或反串的,導致在某些情況下,還是有可能錯用熱門的資料,進而出現像是「用膠水讓起司黏在披薩上」的無用資訊。

面對異常的搜尋結果,團隊只能透過大家的回報,不斷的去改進演算法,或是手動剔除不符合回應來源。

目前 Google 已經導入一些新的機制來改善總結論,包含:

- 新的偵測方案來減少毫無意義的建議或是帶有戲謔內容出現在總結中。

- 限制引用來自用戶隨意建立可能導致錯誤結論的回覆內容。

- 當 AI 無法得出有用內容時,將會觸發搜尋限制。

- 特定類型,如有關健康新聞的查詢,Google 有專門機制在從事資料搜尋,避免 AI 導入過多嚴肅的硬新聞內容,因為即時性與正確性也同樣重要。

Google 會持續監視可能有害的內容,並持續進行修正,目前 AI 給出可能具危險性建議的機率非常低,大約不到 700 萬分之一,多數時間在使用上不必太過擔心,而如果對於 AI 給出的內容覺得不妥,也鼓勵大眾隨時進行回報,讓團隊可以有更多參考。